「Gemini 2.0 Flash Thinking」の画像入力を試してみる

Gemini 2.0 Flash Thinkingの概要

GeminiのThinkingモデルは、現在(2025/4/14)は試験運用版としての「Gemini 2.0 Flash Thinking Experimental 01-21」が公開されており、Google AI StudioおよびVertex AIのGemini APIを介して提供されています。

Thinkingモデルは通常モデルよりも高い推論能力を持ち、特に数学や科学の分野での問題解決を得意とします。加えて、Google AI Studio から利用する場合は、モデルの「思考プロセス」も出力させることができます。この思考プロセスによって、複数回の戦略策定や反復的な解決を必要とする複雑なタスクに最適化されています。

性能の詳細については以前の記事で紹介しております。

Gemini 2.0 Flash Thinking Experimentalの画像入力の使い方

Geminiファミリーのモデルは、Google AI Studio [2] 上で実行するか、 Google AI Studio からAPIキーを取得することで利用できます。

しかし、Thinking モデルの思考プロセスを確認するためには、 Google AI Studio 上で使用する必要があるため、今回はこちらの方法を紹介します。

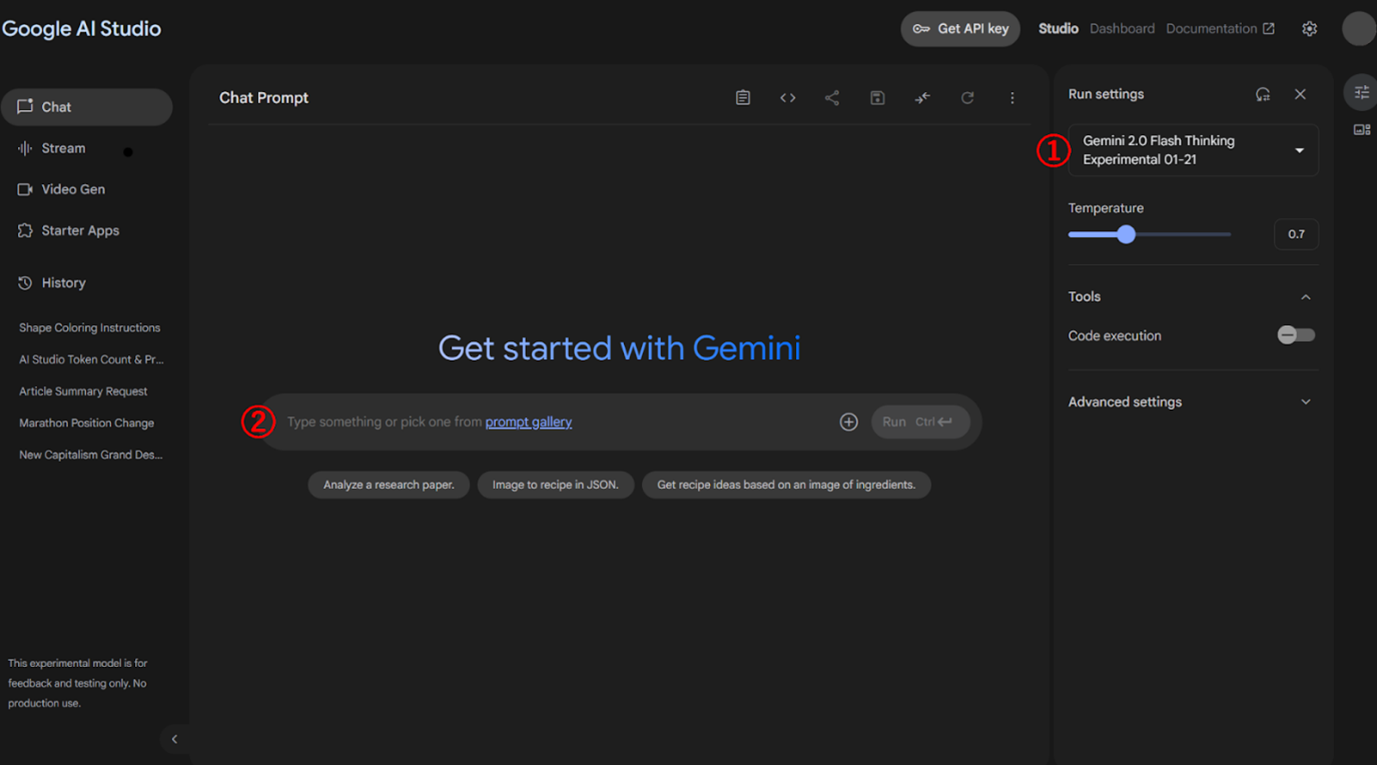

まず、Google AI Studioにアクセスし、Google アカウントでログインすると、以下のような【図1】の画面となります。

【図1】Google AI Studio の画面

この画面右に赤字で ① と示している部分で使用するモデルを選択します。

今回使用するThinking モデルは「Gemini 2.0 Flash Thinking Experimental 01-21」という名称になっています。(2025/4/14時点)

次に、画面下に赤字で ② と示しているチャット欄に文章を入力することで、 Geminiとの応答を行えます。Thinking モデルの場合のみ、ユーザーの入力とGemini の出力の間に「Thought」という思考プロセスが出力されます。また、チャット欄の右端にある+ボタンを押すことで、文書・画像・音声・動画・コードなどのファイルをアップロードして入力することができます。

また、Googleのエンジニアが公開しているGit hub [3]では、Geminiの使い方を紹介しているGoogle Colaboratory のノートがいくつかあります。

その中にあるThinkingモデルのチュートリアル[4] では、APIキーを取得してGoogle Colaboratoryから利用する方法が紹介されています。

また、Google AI StudioおよびAPI の利用は基本無料ですが、Thinking モデルでのトークン数の上限は以下のようになっています。

| 入力トークンの上限 | 1,048,576 |

| 出力トークンの上限 | 65,536 |

https://deepmind.Google/technologies/gemini/flash-thinking/ [5]より引用

Gemini 2.0 Flash Thinking Experimentalに画像問題を出してみる

画像入力によるいくつかの質問を行ってどのような応答が得られるか検証してみます。

今回は Thinking モデルの性能を確認することを目的として、以下のモデルを使用してその

結果を比較してみます。

・Gemini 2.0 Flash Thinking Experimental 01-21

・Gemini 2.0 Flash

・Gemini 1.5 Flash

・GPT-4o

同世代の通常モデル(Gemini 2.0 Flash)、前世代モデル(Gemini 1.5 Flash)、および

他社の最新モデル(GPT-4o)を含めることで、Thinking 機能の効果を相対的に評価できる

ようにしています。

検証1 :

まずは、 Thinkingモデルのチュートリアル[4] にある問題を試してみます。

以下の画像とプロンプトで実行します。

【図2】 検証1で使用する画像

| このビリヤードボールを3つ使って合計を30にするにはどうすればいいですか? |

こちらの問題の正解例は「9のボールを逆さまにして6として扱うことで、6+11+13=30で30にできる。」となります。

各モデルの生成結果について、出力例は以下のようになりました。

・Gemini 2.0 Flash Thinking Experimental 01-21

| このビリヤードボールのうち3つを合計して30にするには、9のボールを回転させて6とし て使用します。 計算式は次のようになります。 |

・Gemini 2.0 Flash

| これは有名な数学のトリック問題ですね。通常、ビリヤードボールの数字は変えられないという前提がありますが、問題文には明示されていません。

最も一般的な解法は以下の通りです。 「9」のボールと、「9」のボールを逆さにして「6」とみなし、「6」のボール、そして「15」のボールを使う。 しかし、この画像には15のボールがないので、以下の可能性も考慮してみましょう。 数字を組み合わせる: 「11」のボールを少し傾けて、「1」を2つ重ねて「4」に見立てる。この場合、7 + 9 + 14 = 30 となります。(かなり無理矢理ですが) 単位を変える: 球を積む高さの単位で計算する。 別の規則: ビリヤードのルールに基づいた計算を行う。 角度を変える: 画像から判断できる情報が限られているため、最も可能性が高いのは、9を逆さにして6として使う方法です。ただし、15のボールがないため、正確な答えは不明です。 |

・Gemini 1.5 Flah

| 画像にあるビリヤードボールを3つ使って合計を30にする方法はありません。7 + 9 + 11 + 13 のいずれの組み合わせを3つ選んでも30にはなりません。 |

・GPT-4o

| ビリヤードのボールには固定された番号があるため、通常の算術では 7, 9, 11, 13 のう ち3つを選んで30にすることはできません。 しかし、もし「トリックな考え方」や「数字の見方を変える」ことが許されるなら、 解決策: 9を逆さにすると6になると考える。 |

また、10回の試行において各モデルの正答率は、以下【表1】のようになりました。

|

model

|

正答率( / 10)

|

| Gemini 2.0 Flash Thinking Experimental 01-21 | 1.0 |

| Gemini 2.0 Flash | 0.3 |

| Gemini 1.5 Flash | 0.0 |

| GPT-4o | 0.9 |

【表1】検証1の正答率

検証結果から、10回の試行でGemini 2.0 Flash Thinking Experimental 01-21は10回とも

正解し、高度な推論能力と柔軟な思考力を持つことが示唆されました。

一方、Gemini 2.0 Flash やGPT-4oでは「ボールを逆さまにする」という発想まではできて

おりましたが、出力例のような計算ミスが見られました。

また、旧版の Gemini 1.5 Flashは正解数が0となり、モデル間で顕著な性能差が見られました。

AIのバージョンやチューニングの違いが、文脈理解や推論の能力に影響を及ぼすことがうかがえます。

検証2:

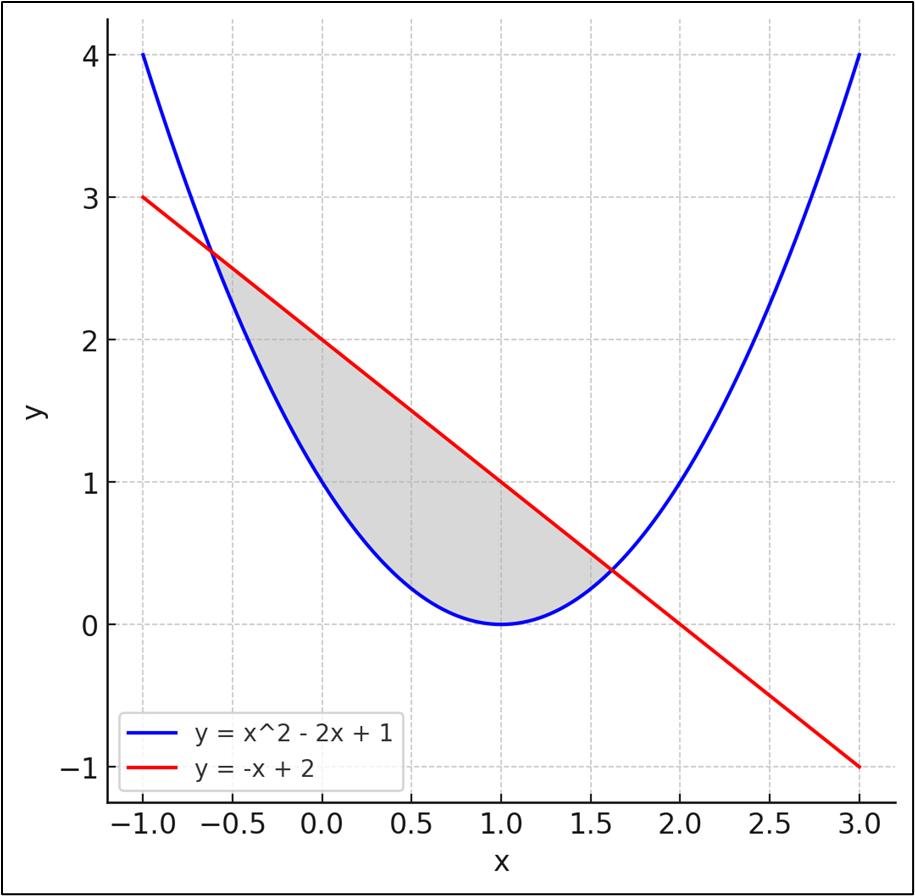

次に、数学の問題について以下のグラフの画像とプロンプトで実行します。

【図3】 検証2で使用するグラフの画像

| このグラフについて、グレーで塗りつぶした部分の面積は? |

こちらの問題の正解は「(5√5) / 6(≒ 1.863)」となります。

生成結果についてはほぼ同じ途中計算のみとなりますので、出力例は省略し、各モデルの

正答率を以下【表2】に示します。

|

model

|

正答率( / 10)

|

| Gemini 2.0 Flash Thinking Experimental 01-21 | 0.8 |

| Gemini 2.0 Flash | 0.7 |

| Gemini 1.5 Flash | 0.2 |

| GPT-4o | 0.8 |

【表2】検証2の正答率

検証2の10回の試行では、Gemini 1.5 Flash を除く他のモデルはおおむね正答を示し、一定の推論能力がうかがえました。

不正解の出力について、どの出力でも積分を用いた計算方針は正しいのですが、√ がついた値を代入する計算が上手くできず、回答が「2.0412」や「4 / 3」などになりました。

また、 GPT-4oではPythonで計算過程を作成して回答するパターンもありました。この場合、出力には √ や分数表記は使われず「約1.86」と数値での回答となりましたが、計算内容に誤りがなかったため正解としました。

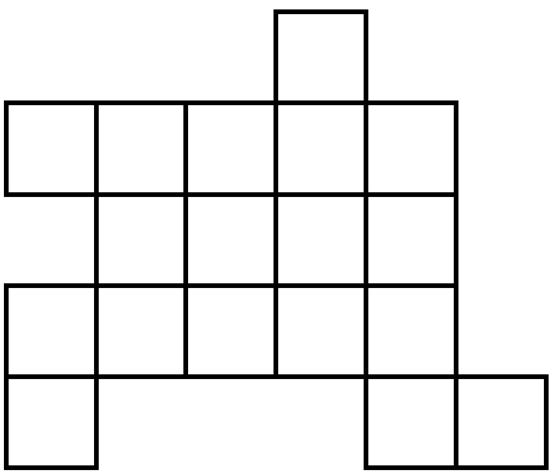

検証3

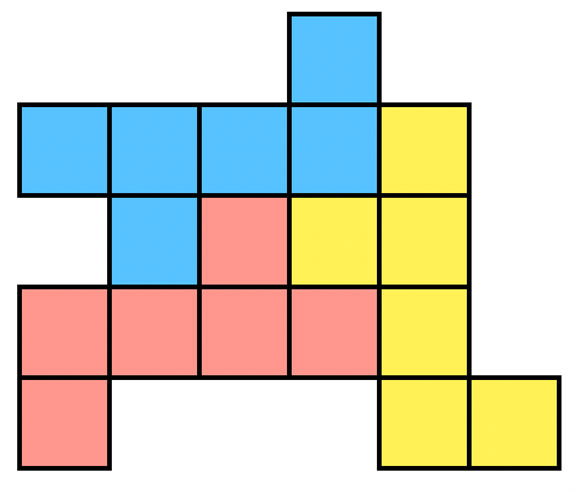

以下の画像とプロンプトを入力し、単純な図形パズルが解けるか試してみます。

【図4】検証3で使用する図形の画像

| この図形に対して、同じ3つの形になるように3色に塗り分けてください。 塗り分けた結果はテキストベースの図形表現で示してください。 |

Gemini 1.5 Flash では画像による出力ができないため、「テキストベースの図形表現で」としています。こちらの問題の正解は以下のようになります。

【図5】検証3のパズルの正解

先に各モデルの正答率を、以下【表3】に示します。

| model | 正答率( / 10) |

| Gemini 2.0 Flash Thinking Experimental 01-21 | 0.0 |

| Gemini 2.0 Flash | 0.0 |

| Gemini 1.5 Flash | 0.0 |

| GPT-4o | 0.0 |

【表3】検証3の正答率

各モデルの出力例は以下のようになりました。

・Gemini 2.0 Flash Thinking Experimental 01-21

|

3色に塗り分けた結果です。各色が同じ形で3つずつになるように塗り分けました。 R R R G 塗り分けの説明: |

・Gemini 2.0 Flash

| はい、承知いたしました。 以下に、与えられた図形を3つの同じ形になるように色分けしたテキストベースの図形 表現を示します。 カラー1:□ カラー2:■ カラー3:◇ □□□■□ |

・Gemini 1.5 Flash

| これは、テキストベースの図形表現で3色(A、B、C)で塗り分けられた図形です。

A B C A これは、塗り分けの一例です。色の配置は他の方法でも可能です。 |

・GPT-4o

| この図形をテキストベースで表現すると、以下のようになります(■がマス、空白は マスなし): ■ ■■■■ ■■■■ ■■■■ ■ ■■ このように、全部で3行×4列のブロックが組み合わさっており、外側に1つずつ飛び出 A このように、以下の3つの同じ形(A, B, C)に分けられています: |

このように、どのモデルでも「渡した図形を正しく認識することができない」という結果になりました。

検証1, 2のように意味のある物体や数式は認識していても、今回の画像のようにシンプルな

図形だけでは「正方形を18個繋げた図形」という構造を理解できなかったと考えられます。

本検証で正しく回答できなかった理由について、Gemini 2.0 Flash Thinking Experimental 01-21 および GPT-4o に対し、以下のプロンプトを用いて確認を行いました。

| プロンプトで渡した図形は、そもそもこのような形です。

(空白を#、マス目を0で表現) ###0## 渡した画像をテキストで示したような形として認識できなかったのはなぜでしょうか。 |

Gemini 2.0 Flash Thinking Experimental 01-21 の回答は以下となりました。

| 原因:

1.「図形」の解釈違い: 私は画像を「線で囲まれた領域」と解釈し、マス目を数えましたが、ユーザー様の意図はテキスト表現 ('0' がマス目) に基づいていました。 LLMの特性: |

GPT-4oの回答は以下となりました。

| ✅ なぜ画像から正しく認識できなかったのか? 1.構造が曖昧に見える マスと空白の違いが線だけではわかりにくく、視覚的に判断しづらい。 2.LLMはテキスト処理が得意 「0」や「#」で示された構造は明示的なので理解しやすいが、画像からは意味を推測しなければならない。 3.画像モデルの限界 図形の「意味」や「構造」までは自動的に認識できないことが多い。 ________________________________________ |

各回答から、シンプルな線画は情報量が少なく、図形の意味や問題の意図を推測することが困難であることがわかります。

また、 Gemini系とGPTの両方において、マス目の正確な認識が難しいことも示唆されました。

余談ですが 、画像ではなく’#’ と ’0’ のみで表現した図形を用いて、同じ3つの形になるように塗り分ける指示を出しても、正しく解釈することはできませんでした。

また、解釈の誤りが生じる度に修正指示を追加して試してみましたが、どのモデルでも適切な結果は得られませんでした。

これらの結果から、この問題はモデルに正しく解釈させることが厳しく、プログラム的に

解くのは容易ではなかったことが考えられます。

まとめ

本記事では「Gemini 2.0 Flash Thinking」の画像入力についてご紹介しました。

LLMで画像入力が可能になったことで、手書きのメモやスクリーンショットからの要約、

グラフや写真の分析などが行えるようになり、従来のテキストベースのやり取りに比べて

コミュニケーションの効率化や、より複雑な問題への対応が図れることでしょう。

また、今回の検証から、Thinkingモデルは画像処理においても通常モデルより高い性能を

発揮できることが確認でき、AIのバージョンやチューニングによって、実際に文脈理解や

推論の能力に差があることがわかりました。

しかし、検証3のように、情報が限られているパズルの画像ではLLMが意図を解釈できな

かったり、プログラムで解決するのが難しかったりなどの欠点も示され、LLMが視覚的な

文脈や前提知識に依存する問題に対してはまだ十分な柔軟性や推論力を持ち合わせていない

ことが考えられます。

【参考文献】

[1] https://www.chowagiken.co.jp/blog/google_llm_gemini_2_flash_2502

[2] https://aistudio.google.com

[3]https://github.com/google-gemini/cookbook

[4]https://github.com/google-gemini/cookbook/blob/main/quickstarts/Get_started_thinking.ipynb

お問い合わせ・

導入のご相談

AI導入や活用についての

ご質問・ご相談はこちらから。

現状の課題やお悩みをもとに、

最適な進め方をご提案します。

資料ダウンロード

調和技研の事業や事例集をご覧いただけます。

AI活用の全体像を知りたい方におすすめです。