手書き訂正などが書き込まれた書類の、LLMを使った読み取り実験

使用モデル

Gemini:Gemini-2.5-flash

chatGPT:GPT-5(Auto)

Claude:Sonnet 4

※LINKS Vedaプロトタイプ開発レポートでは、Azure AI Document Intelligence (version 3.1)をOCR処理に利用

検証概要

LINKS Vedaプロトタイプ開発レポートにおいて、OCRによる正確な情報抽出が困難なケースとして報告されたものから情報が抽出できるか確認。

検証概要

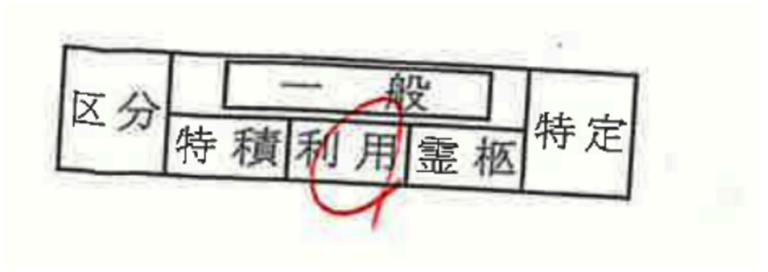

1.申請書における選択肢の丸囲みや四⾓囲みの表現

▍対象画像①

▍対象画像②

▍プロンプト

選択された申請区分を抽出して

▍結果 ①

|

モデル |

LLM出力結果 |

|

Gemini-2.5-flash |

抽出された申請区分は「地域DMO」です。 |

|

GPT-5(Auto) |

画像から選択されている申請区分は 「地域DMO」 です。 |

|

Sonnet 4 |

画像を確認しました。選択された申請区分は「地域DMO」です。 右端の「地域DMO」の項目が四角で囲まれており、これが選択されていることを示しています。 |

▍結果 ②

|

モデル |

LLM出力結果 |

|

Gemini-2.5-flash |

抽出された申請区分は「利用」です。 |

|

GPT-5(Auto) |

画像から赤丸で選択されている申請区分は 「利用」 です。 |

|

Sonnet 4 |

画像を確認しました。赤い円で囲まれている申請区分は「利用」です。 |

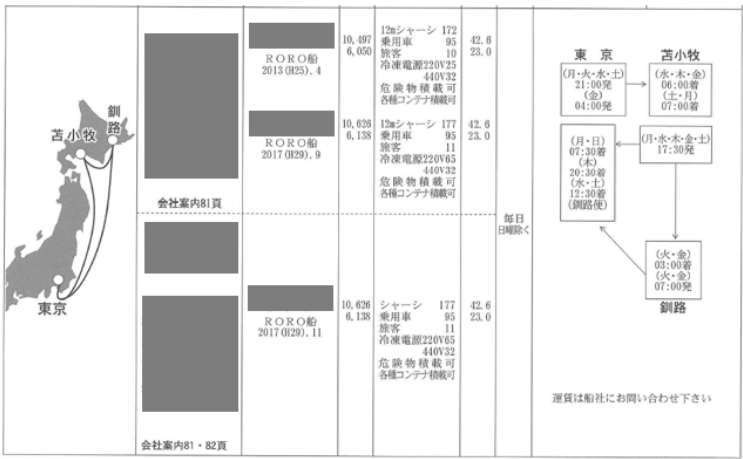

2.⽮印などのオブジェクトが入った複雑な図

▍対象画像

▍プロンプト

画像は海上定期便ガイドです。運航スケジュールを抽出してください。

▍結果

LINKS Vedaプロトタイプ開発レポートでは、

「地理的関係や移動航路の表現に⽮印が使われており、⽮印が「東京から苫⼩牧への出港

スケジュール」という関係性を⽰しています。⼈間なら⽮印の⽅向から各地点間の発着関係を理解できるが、AI はこの視覚的な情報を理解するのが難しく、単なる線として認識して

しまう。」という課題が提起されていました。

最新のモデルでは、運航時刻の値が一部不正確であるが、関係を認識できています。 Claudeは「苫小牧」が「古小牧」となっていたり、日本語があまり得意でない傾向が出ています。

|

モデル |

LLM出力結果 |

|

Gemini-2.5-flash |

画像から抽出した海上定期便の運航スケジュールは以下の通りです。 東京発 → 苫小牧行 苫小牧発 → 釧路行 ――― |

|

GPT-5(Auto) |

画像から抽出した運航スケジュールは以下の通りです。 ●東京発 → 苫小牧着 ●苫小牧発 → 東京着 月・日:07:30 発 苫小牧 ⇔ 釧路 |

|

Sonnet 4 |

画像から海上定期便の運航スケジュールを抽出します: 運航スケジュール 便1 出発時刻: 10時407分(6時050分) 便2 出発時刻: 10時620分(6時138分) 便3 出発時刻: 10時620分(6時138分) 注意: 運賃は船舶にお問い合わせください |

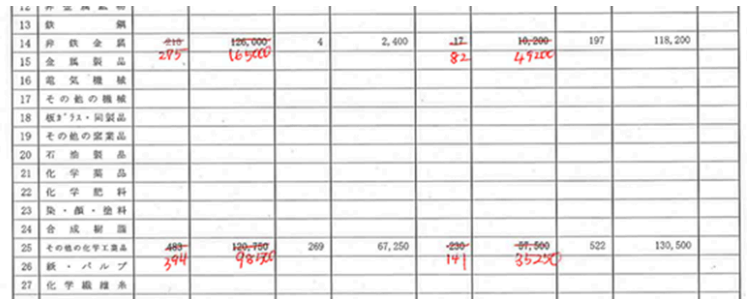

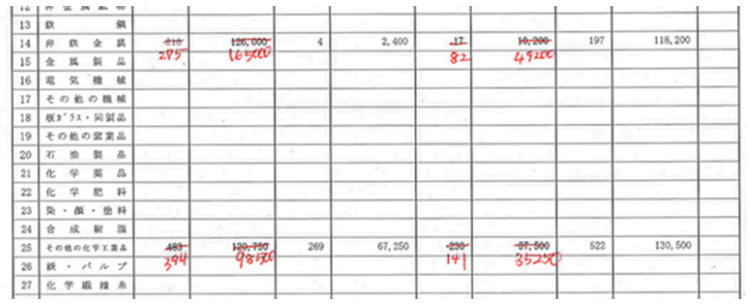

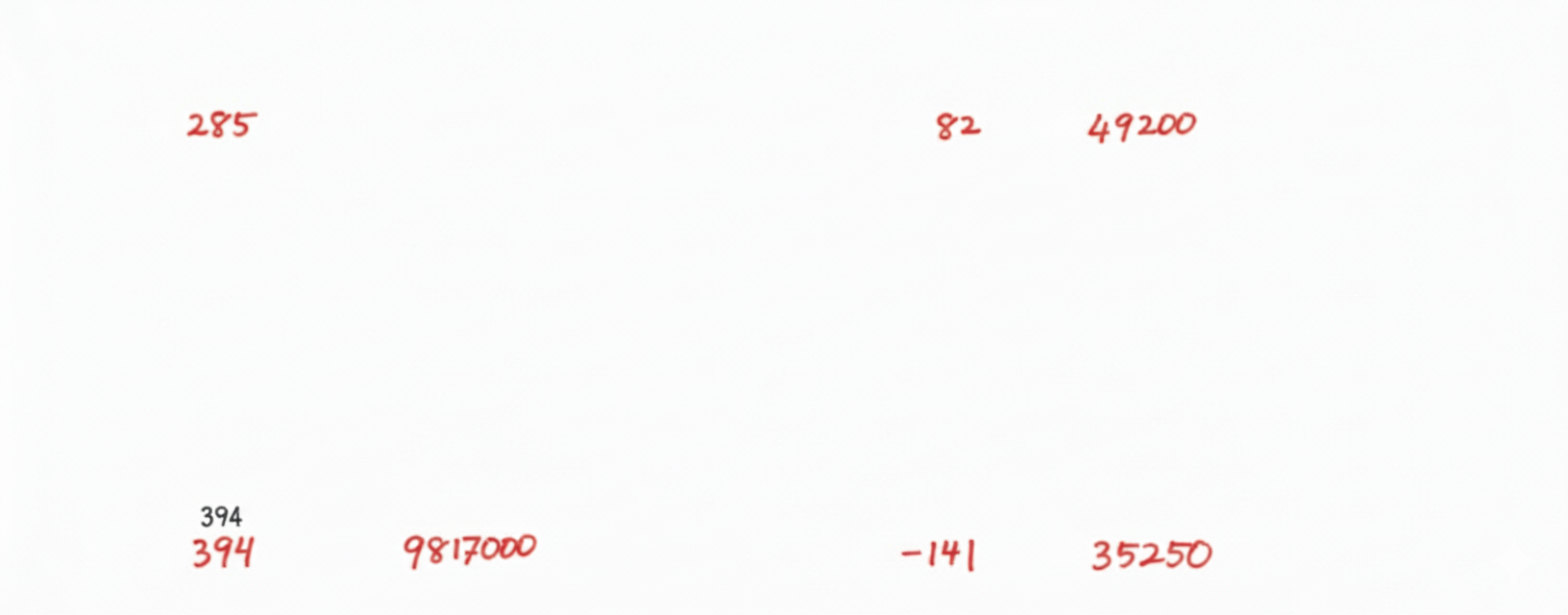

3.訂正線や⼿書きによる修正などのイレギュラーな記載

▍対象画像

▍プロンプト

画像は報告書です。手書きで数値を修正しています。この表の内容を訂正前後の値が分かるようにJSON化してください

▍結果

LINKS Vedaプロトタイプ開発レポートでは、

「数値や⽂字に訂正線が引かれ、新しい値が記⼊されている場合、OCRは訂正前の値と訂正後の値を区別できず、誤った情報を抽出してしまう。訂正して別の数値などで上書きした場合、⼈間なら訂正線と新しい数値から正しい⾦額を読み取れるが、AIは両⽅の数値を検出し、どちらが有効な情報なのか判断できない。」

という課題を提起していました。

GeminiとGPTは数値に一部不正確であるが変更箇所(訂正の前後関係)を認識できており、項目名や数値も安定して抽出できる傾向にあります。

Claudeはそもそもの修正箇所、項目名などの抽出が困難でした。モデルをOpus 4.1に変更

しても性能に大きな変わりはなかったため、日本語の表+手書き訂正はClaudeには難しい

分野であることが推測できます。

|

モデル |

LLM出力結果 |

|

Gemini-2.5-flash |

[ |

| GPT-5(Auto) |

{ |

|

Sonnet 4 |

{ |

結論

今回の検証から、従来OCRやRPAでは困難とされてきた

● 選択肢の丸囲み・四角囲み

● 矢印を含む複雑な図の読み取り

● 訂正線や手書き修正を含む表の解釈

といったケースに対し、最新の大規模言語モデル(Gemini、GPT-5、Claude)は一定の改善を示しました。

特に Gemini と GPT-5 は、修正前後の数値や矢印による関係性をある程度認識でき、安定した抽出結果を返す傾向が確認されました。一方で、Claudeは日本語の表記や手書き訂正の処理に弱みがあり、誤認識や項目抽出の欠落が多く見られました。

ただし、いずれのモデルも完全な正確性には至らず、数値や時刻の一部に誤りが残るなど、実運用での単独利用にはリスクがあります。したがって、実際の行政文書処理やビジネス活用においては、

〇 OCR+LLMのハイブリッド活用

〇 モデル出力に対する人間による最終確認

〇 日本語表記や特殊記号への追加チューニング

といった補助的仕組みを組み合わせることが有効と考えられます。

総じて、最新LLMは従来困難であった手書き要素や複雑な図表を読み解く能力を着実に高めており、行政文書や業務書類のデジタル化に向けた実用可能性が広がっていると結論づけられます。

今回確認したすべてのモデルにおいて、訂正箇所を反映した画像に変換するのは困難でした。ただし、Gemini(gemini-2.5-flash-image(通称:Nano Banana))では、手書き部分のみを抽出することができました。この差分情報を使用することで、抽出精度の向上など将来的に考えられます。

↓

GeminiやGPTでは手書きのあり/なし判定ができるので、LLMにとって難しそうな箇所だけ、結論に書いたような補助処理に回すということも可能です。

ちなみに今回の行政文書の件とはちょっと話題変わりますが、「PDFデータの内容を検索したいとき、OCRではなく、画像のままLLMに理解させてそれをベクター化させるほうが精度が良かった」 という報告も最近上がってきています。

(参考:https://x.com/yuma_prog/status/1969273067709853808?t=a8Pw_6QZxqcHr_VILhgSog&s=31)

【参考】

[1] 国土交通省が行政文書をLLMで構造化、ドローン安全運行などに生かす | 日経クロステック(xTECH)

[3]【13万バズ】📝手書きメモ→写真だけでテキスト化!Geminiが最強。& さらに精度を高めるテクニック、注意点を一挙に解説|たてばやし淳.エクセル兄さん@ AI書籍10冊執筆

お問い合わせ・

導入のご相談

AI導入や活用についての

ご質問・ご相談はこちらから。

現状の課題やお悩みをもとに、

最適な進め方をご提案します。

資料ダウンロード

調和技研の事業や事例集をご覧いただけます。

AI活用の全体像を知りたい方におすすめです。